Met lineaire regressie kun je een model maken wat de relatie beschrijft tussen verklarende variabelen (X) en een uitkomstvariabele (Y). Lineaire regressie is een veelgebruikte modelleringstechniek die zowel bij wetenschappelijke onderzoeken als in het bedrijfsleven wordt gebruikt.

In dit blog leer je:

- Wat is lineaire regressie?

- Welke assumptions kent lineaire regressie? (in Nederlands: assumpties of aannames)

- 4 assumptions om te checken bij de verklarende variabelen

- 3 assumptions om te checken bij residuen

1. Wat is lineaire regressie?

Zoals gezegd: Met lineaire regressie kun je een model maken wat de relatie beschrijft tussen verklarende variabelen (x) een uitkomstvariabele (Y).

Denk hierbij bijvoorbeeld aan:

- Het voorspellen van de optimale medicatiedosis gebaseerd op het gewicht van de patiënt.

- Het voorspellen van een salaris gebaseerd op een uurtarief.

Bij een model stop je er iets in, en er komt iets uit. De volgende termen worden hierbij veelal door elkaar gebruikt:

- Verklarende variabelen, ook wel genoemd: onafhankelijke variabelen, explanatory variables, inputs, of X

- Uitkomstvariabele, ook wel genoemd: de afhankelijke variabele, output, of Y

Grofweg wordt over 2 soorten van complexiteit gesproken:

- Univarate lineaire regressie: er is één verklarende variabele om de uitkomst te voorspellen. Dit noemt men ook wel simple linear regression of enkelvoudige lineaire regressie.

- Multivarate lineaire regressie: er zijn meerdere verklarende variabele om de uitkomst te voorspellen. Dit noemt men ook wel multiple linear regression of meervoudige lineaire regressie.

Formule

De formule voor lineaire regressie is als volgt:

y = a1x1 + a2x2 + ... + anxn + b + ε

Waarin:

- y: De uitkomstvariabele.

- b: De interceptcoëfficiënt: indien waarden van allemaal nul zijn, is dit het punt waarop de lijn de y-as kruist.

- a1 t/m an: De regressie hellingscoëfficiënten.

- x1 t/m xn: De verklarende variabelen.

De set waarden van de verklarende variabelen die tot een bepaald waarde van de uitkomstvariabele leidt, wordt een observatie genoemd.

Bijvoorbeeld in een medisch onderzoek zijn de observaties de verzamelingen metingen die op verschillende patiënten zijn uitgevoerd.

Het verschil tussen de werkelijke uitkomst en de voorspelde uitkomst wordt de afwijking (ook: error, residu) genoemd.

2. Linear regression assumptions: essentiële assumpties

Om een lineair regressie model succesvol en betrouwbaar bruikbaar te maken zijn er enkele assumptions (in Nederlands: assumpties of aannames) die je dient te controleren.

Deze zijn onder te verdelen in van toepassing zijnde op (1) de verklarende variabelen en (2) de residuen:

Assumptions om te checken bij de verklarende variabelen

- Onafhankelijke observaties

- Geen verborgen of missende variabelen

- Lineaire relaties met afhankelijke variabele

- Geen of weinig multicollineariteit

Assumptions om te checken bij residuen

- Normaal verdeeld

- Homoscedasticiteit

- Geen of weinig autocorrelatie

We zullen deze assumpties nader toelichten in de volgende paragrafen.

3. Assumptions om te checken bij de verklarende variabelen

3.1 Onafhankelijke observaties

De observaties moeten onafhankelijk zijn. Onafhankelijke observaties betekent dat er geen relaties aanwezig zijn tussen verschillende observaties. Dus: dat de ene observatie geen invloed heeft op de andere observatie.

Er zijn 3 veelvoorkomende oorzaken van afhankelijke observaties:

- Observaties zijn dicht bij elkaar in tijd. Een voorbeeld hiervan is: Je onderzoekt de drukte op een weg maar doet dit alleen tijdens de spits.

- Observaties zijn dicht bij elkaar in plaats. Voorbeeld: Je onderzoekt het gemiddelde inkomen in een stad maar neemt alleen maar metingen in 1 wijk.

- Observaties komen meerdere keren voor. Voorbeeld: Sommige deelnemers aan een onderzoek doen meermaals mee.

De beste manier om onafhankelijke observaties te garanderen is om vooraf een goede onderzoeksmethode te bepalen. Waarbij afhankelijke observaties niet voor kunnen komen.

3.2 Geen missende variabelen

Er mogen geen onafhankelijke variabelen missen. Het model moet alle variabelen bevatten die de variatie van de afhankelijke variabele omschrijven.

Een oorzaak hiervan kan zijn dat voorafgaand aan een onderzoek nog niet duidelijk is welke variabelen invloed hebben op de afhankelijke variabele.

Je kunt missende variabelen voorkomen door:

- Voorafgaand aan een onderzoek experts mee laten denken over wat gemeten zou moeten worden.

- Als je voorafgaand aan een onderzoek alsnog onzeker bent kun je het onderzoek met een relatief kleine testpopulatie beginnen, om vervolgens daar waar dit uit de resultaten blijkt aanpassingen te doen.

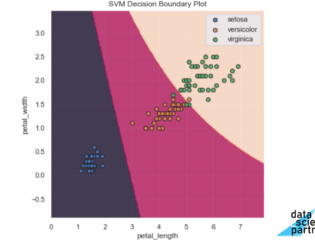

3.3 Lineaire relaties met afhankelijke variabele

De onafhankelijke variabelen moeten lineaire relaties hebben met de afhankelijke variabele. Dit omdat er een lineair model wordt gemaakt.

Sommige relaties zijn niet lineair. In dit geval is lineaire regressie niet zomaar te gebruiken.

Je kunt lineaire relaties testen door:

- Het maken van een scatter plot tussen elk van de verklarende variabelen en de uitkomstvariabele. De punten moeten een denkbeeldige lineaire lijn volgen.

- Het berekenen van correlatiecoëfficiënten tussen elk van de verklarende variabelen en de uitkomstvariabele. Er moet correlatie zijn.

In een scatter plot kun je ook goed zien of er outliers voorkomen. Lineaire regressie is gevoelig voor outliers dus deze dien je te verwijderen.

Je kunt niet-lineaire relaties voorkomen door het toepassen van niet-lineaire transformaties op de uitkomstvariabele en/of de verklarende variabelen. Denk hierbij aan normaliseren, logs van waarden, etc.

3.4 Geen of weinig multicollineariteit

Er mag geen multicollineariteit aanwezig zijn. In andere woorden: de verklarende variabelen mogen onderling niet gecorreleerd zijn. Wanneer dit wel het geval is wordt er extra complexiteit aan het model toegevoegd zonder dat het model de impact hiervan kan beschrijven.

Een voorbeeld van multicollineariteit zou kunnen zijn: je doet onderzoek naar salaris en neemt zowel het aantal dienstjaren en de leeftijd mee als verklarende variabelen. Dienstjaren en leeftijd zouden wel eens met elkaar gecorreleerd kunnen zijn.

Je kunt multicollineariteit testen door:

- Correlaties tussen variabelen te berekenen.

- Scatter plots tussen variabeles te maken.

- Variance Inflation Factor (VIF) scores te berekenen.

- VIF gelijk aan 1: Variabelen zijn niet gecorreleerd.

- VIF tussen 1 en 5: Variabelen zijn matig gecorreleerd.

- VIF groter dan 5: Variabelen zijn sterk gecorreleerd.

Je kunt multicollineariteit voorkomen door: verminder de dimensionaliteit van verklarende variabelen met behulp van bijvoorbeeld een Principal Component Analysis (PCA).

4. Linear Regression assumptions om te checken bij residuen

4.1 Zijn residuals normaal verdeeld?

De residuen moeten normaal verdeeld zijn.

Je kunt normaliteit van de residuen testen door:

- Een histogram te maken van de residuen. Beoordeel de verdeling visueel.

- Een Q-Q plot (quantile-quantile plot) te maken. Bij benadering moeten de punten de identity line (y=x) volgen. Zie je iets als een S-vorm, een exponentiele curve of welke andere vorm dan een rechte lijn: de residuen zijn dan niet normaal verdeeld.

Je kunt niet voldoen aan normaliteit van de residuen voorkomen door:

- Toevoegen/aanpassen van verklarende- en/of uitkomstvariabele(n).

- Gebruik van een niet-lineair model.

4.2 Homoscedasticiteit

In geval van homoscedasticiteit zijn de residuen constant over de variatie in voorspelde uitkomsten. Dit leidt er bijvoorbeeld toe dat hogere uitkomstwaarden betrouwbaarder voorspeld zijn dan lagere uitkomstwaarden.

Je kunt homoscedasticiteit testen door een scatter plot te maken tussen waarden van de afhankelijke variabele en de residuen. De residuen moeten een constante afstand tot y=0 hebben.

Je kunt niet voldoen aan homoscedasticiteit voorkomen door:

- Aanpassen van verklarende- en/of uitkomstvariabele(n).

- Gebruik van het weighted least squares model.

- Gebruik van een niet-lineair model.

4.3 Geen of weinig autocorrelatie

Autocorrelatie mag niet tot nauwelijks voorkomen. Dit betekent dat de residuen niet afhankelijk van elkaar mogen zijn. Dit kan voorkomen bij onderzoeken in de tijd.

Denk hierbij bijvoorbeeld aan het voorspellen van een beurskoers, daarbij is de huidige prijs afhankelijk van de vorige prijs.

Je kunt autocorrelatie testen door de residuen te plotten tegen te volgorde waarin ze berekend zijn. Er mogen geen patronen waarneembaar zijn.

Je kunt autocorrelatie voorkomen door een ander model te gebruiken zoals een time series model.

5. Tot slot

- In dit blog heb je geleerd wat lineaire regressie is. Het maken van een lineair model wat de relatie beschrijft tussen verklarende variabelen (x) een uitkomstvariabele (Y).

- Voor veel termen zijn verschillende uitdrukkingen.

- Om een lineair regressie model betrouwbaar te kunnen gebruiken moet er voldaan zijn aan verschillende assumptions/assumpties.

Een Linear Regression model stap voor stap toepassen met Python is onderdeel van onze machine learning training, data science opleiding, en data science bootcamp. Dus wil jij je ontwikkelen of omscholen tot data scientist en in staat zijn om nog nauwkeurigere voorspellingen te kunnen doen? Schrijf je dan in of neem contact met ons op voor meer informatie.

Download één van onze opleidingsbrochures voor meer informatie

Peter is een ervaren data scientist en python trainer. Na zijn studie aan de Technische Universiteit Delft heeft hij zich altijd bezig gehouden met data en diverse programmeertalen. Peter heeft veel data analyses uitgevoerd en processen geautomatiseerd met Python in productieomgevingen.