De termen "Large Language Model" en "Generative AI" worden vaak door elkaar gebruikt. Je komt deze termen tegen wanneer het gaat over AI-tools zoals ChatGPT. Hoewel de termen nauw met elkaar zijn verbonden zijn er zowel overeenkomsten als verschillen. In deze blogpost bekijken leer je wat beide termen betekenen en hoe ze zich tot elkaar verhouden.

1. Wat zijn Large Language Models (LLMs)?

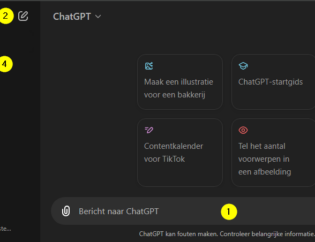

Large Language Models (LLMs) zijn modellen die gebruik maken van kunstmatige intelligentie (AI), en zijn speciaal ontworpen om menselijke taal te begrijpen en te kunnen genereren. Ze maken gebruik van complexe neurale netwerken en zijn getraind op grote hoeveelheden datasets met tekst zoals artikelen en websites. Een voorbeeld van een LLM is het GPT-4o model van OpenAI, wat je toepast als je ChatGPT gebruikt.

2. Wat is Generative AI?

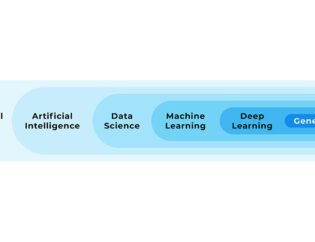

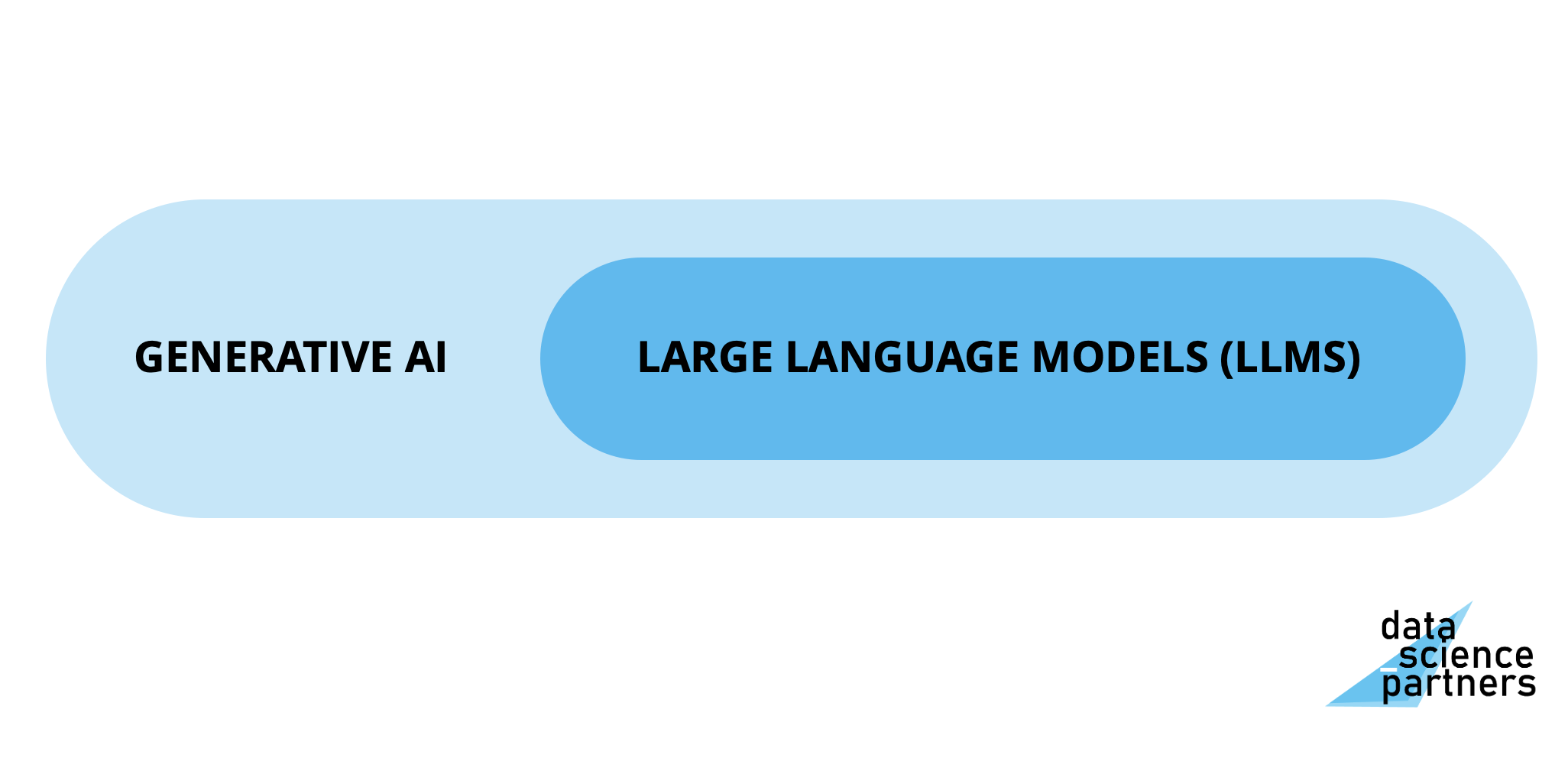

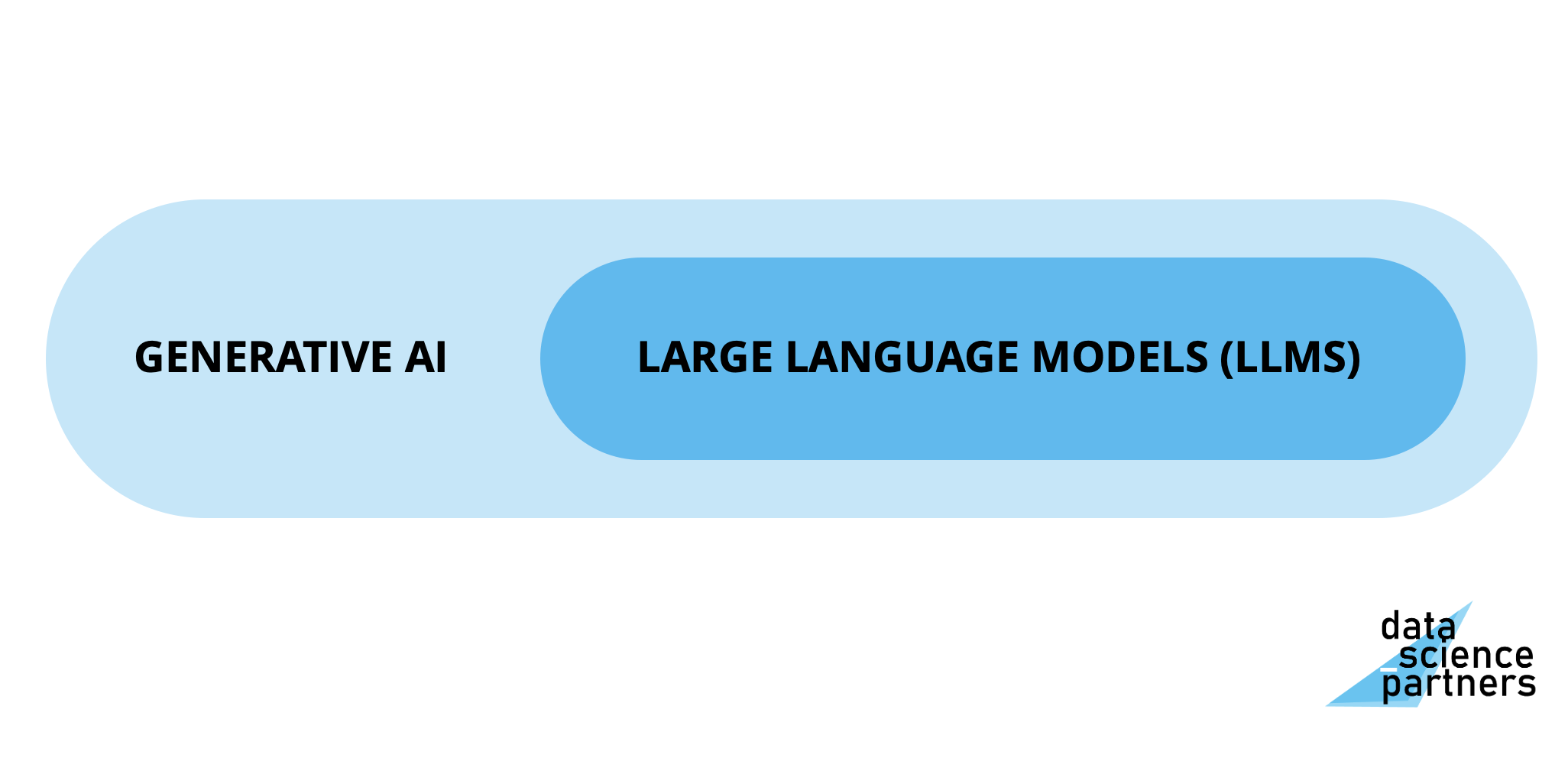

Generative AI verwijst naar een overkoepelendere categorie van kunstmatige intelligentie met modellen die in staat zijn om allerlei soorten nieuwe content te creëren. Zoals een LLM wat tekst kan generren, maar ook modellen die afbeeldingen (denk aan DALL-E en Midjourney), muziek of video's kunnen genereren vallen eronder.

Large Language Models zijn dus een subgebied binnen generative AI. Met deze kennis kijken we verder naar enkele verschillen en overeenkomsten tussen de twee termen.

3. Verschillen

Verschil 1: Scope

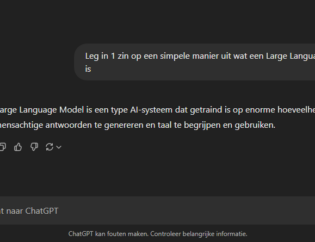

- LLMs: Large Language Models zijn ontworpen voor het werken met uitsluitend tekstdata. Ze kunnen daarbij voor allerlei toepassingen worden gebruikt, zoals het beantwoorden van vragen, vertalen van teksten, of het samenvatten van artikelen.

- Generative AI: Generative AI is een verzamelterm voor AI-modellen die content genereren. Het omvat niet alleen modellen die werken met tekst (LLMs), maar ook modellen die werken met afbeeldingen/foto's, geluiden en video's.

Voorbeeld: ChatGPT genereert output met AI en is daardoor een voorbeeld van generative AI. Het maakt daarbij gebruik van een LLM. DALL-E is ook een Generative AI-model, het genereert afbeeldingen op basis van prompts. Maar het is geen LLM.

Ook interessant: hoe werkt ChatGPT?

Verschil 2: Trainingsdata

Tijdens het trainingsproces doen modellen ervaring op met bestaande data, en ontdekken hier patronen in.

- LLMs: Deze modellen worden specifiek getraind op datasets met teksten, zoals boeken, wetenschappelijke artikelen, websites en forums. Hierbij leert een model technische kennis van taal en inhoudelijke kennis van specifieke onderwerpen. Deze kennis wordt nadien ingezet om nieuwe teksten te kunnen genereren.

- Generative AI: Doordat generative AI een verzamelterm is kunnen modellen getraind worden op verschillende soorten data (tekst, foto's, video's), afhankelijk van het doel van een model.

Voorbeeld: OpenAI LLM GPT-4 werd getraind op een grote verzameling tekstdata, terwijl een het model van Midjourney op miljoenen afbeeldingen is getraind.

Verschil 3: Output

- LLMs: Een LLM genereert tekst. Dit kan onder andere een antwoord zijn op een vraag, een volledig nieuw geschreven tekst zoals een e-mail, of kan bijvoorbeeld een stuk code in een programmeertaal zijn.

- Generative AI: Omdat generative AI een verzamelterm is, is de output ervan diverser. Afhankelijk van het type model kan de output bijvoorbeeld tekst, afbeeldingen, muziek, of video's zijn.

Voorbeeld: Terwijl een LLM zoals GPT-4 tekst genereert, kan een generative AI-model zoals RunwayML video’s genereren.

4. Overeenkomsten

Overeenkomst 1: Transformer-architectuur

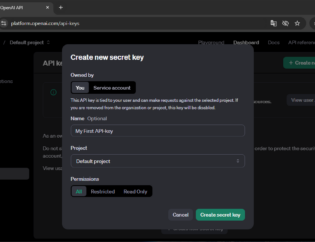

Zowel Large Language Models als veel Generative AI-modellen maken gebruik van neurale netwerken in een transformer-architectuur: een complexe structuur die op het de werking van het menselijke brein is gebaseerd. De transformer-architectuur maakt het mogelijk om grote hoeveelheden data efficiënt te verwerken en daarbij complexe patronen te kunnen herkennen. Daarnaast zijn voor beiden vaak APIs beschikbaar zoals bijvoorbeeld de ChatGPT API

Voorbeeld: GPT-4 (LLM, generative AI) en DALL-E (generative AI, geen LLM) maken allebei gebruik van modellen in transformer-architectuur.

Overeenkomst 2: Creatieve mogelijkheden

Zowel LLMs als Generative AI-modellen bieden tal van creatieve mogelijkheden. Ze kunnen content creëren die door mensen als origineel of nieuw wordt beschouwd. Hoewel de input/prompt door een mens ingevoerd kan worden, biedt de creativiteit van deze modellen mogelijkheden voor innovatie op allerlei gebieden zoals kunst, literatuur, technologie en entertainment.

Voorbeeld: ChatGPT kan bijvoorbeeld helpen bij het schrijven van een roman, DALL-E kan unieke visuele kunst creëren.

Overeenkomst 3: Gebruik van grote datasets

Zowel LLMs als Generative AI-modellen worden getraind op enorme datasets. Dit kan gaan om datasets van bijvoorbeeld tekst, afbeeldingen of video's. De kracht van allebei ligt in het vermogen om grote hoeveelheden data te verwerken en daaruit patronen te leren die nadien gebruikt kunnen wordenom nieuwe content te genereren.

Voorbeeld: LLM GPT-4 werd getraind op biljoenen woorden. Een model als Stable Diffusion is getraind op miljoenen afbeeldingen om visuele output te kunnen creëren.

Conclusie

Hoewel Large Language Models en Generative AI vaak hand in hand gaan, zijn er duidelijke verschillen in hun scope, output, en toepassingen. LLMs richten zich voornamelijk op tekst en taalverwerking, terwijl Generative AI een breder veld beslaat en content in verschillende vormen kan genereren. Wat ze echter gemeen hebben, is hun vermogen om creatief te zijn en gebruik te maken van dezelfde transformer-architectuur.

Wil je allround AI expert worden?

Tijdens onze AI Opleiding leer je het hele AI spectrum kennen; van klassieke machine learning modellen tot generative AI met o.a. ChatGPT. Je leert programmeren in Python zodat je op uiteenlopende vlakken aan de slag kunt met AI.

Peter is een ervaren data scientist en python trainer. Na zijn studie aan de Technische Universiteit Delft heeft hij zich altijd bezig gehouden met data en diverse programmeertalen. Peter heeft veel data analyses uitgevoerd en processen geautomatiseerd met Python in productieomgevingen.